Ollama

Get up and running with large language models.

ollama.com

로컬 환경에서 LLM을 다운로드하여 사용하는 과정에는 번거로운 작업이 많다.

Ollama라는 오픈소스를 통해 다양한 LLM을 편리하게 다운로드하여 사용할 수 있다.

Ollama로 llama3.1을 사용해 보는 과정을 알아보자.

위 주소에서 Ollama를 다운받아 설치하면, 터미널에서 `ollama` 를 통해 LLM을 사용할 수 있다.

먼저 사용할 모델을 다운받기 위해 라이브러리를 찾아본다.

library

Get up and running with large language models.

ollama.com

나는 llama3.1을 사용할 것이다.

llama3.1은 파라미터 크기별로 3가지 모델을 볼 수 있다.

로컬에서 감당 가능한 용량을 확인하여 고르면 될 것 같다.

8b 시험으로 사용해보고, 231GB 용량의 405b 모델을 설치했다.

=> 자체 용량과 별개로 램 부족 때문에 안 돌아간다. 택도 없는 것 같다.

아래 터미널 명령을 통해 해당 모델을 실행할 수 있다. 모델이 없으면 다운로드가 진행된다.

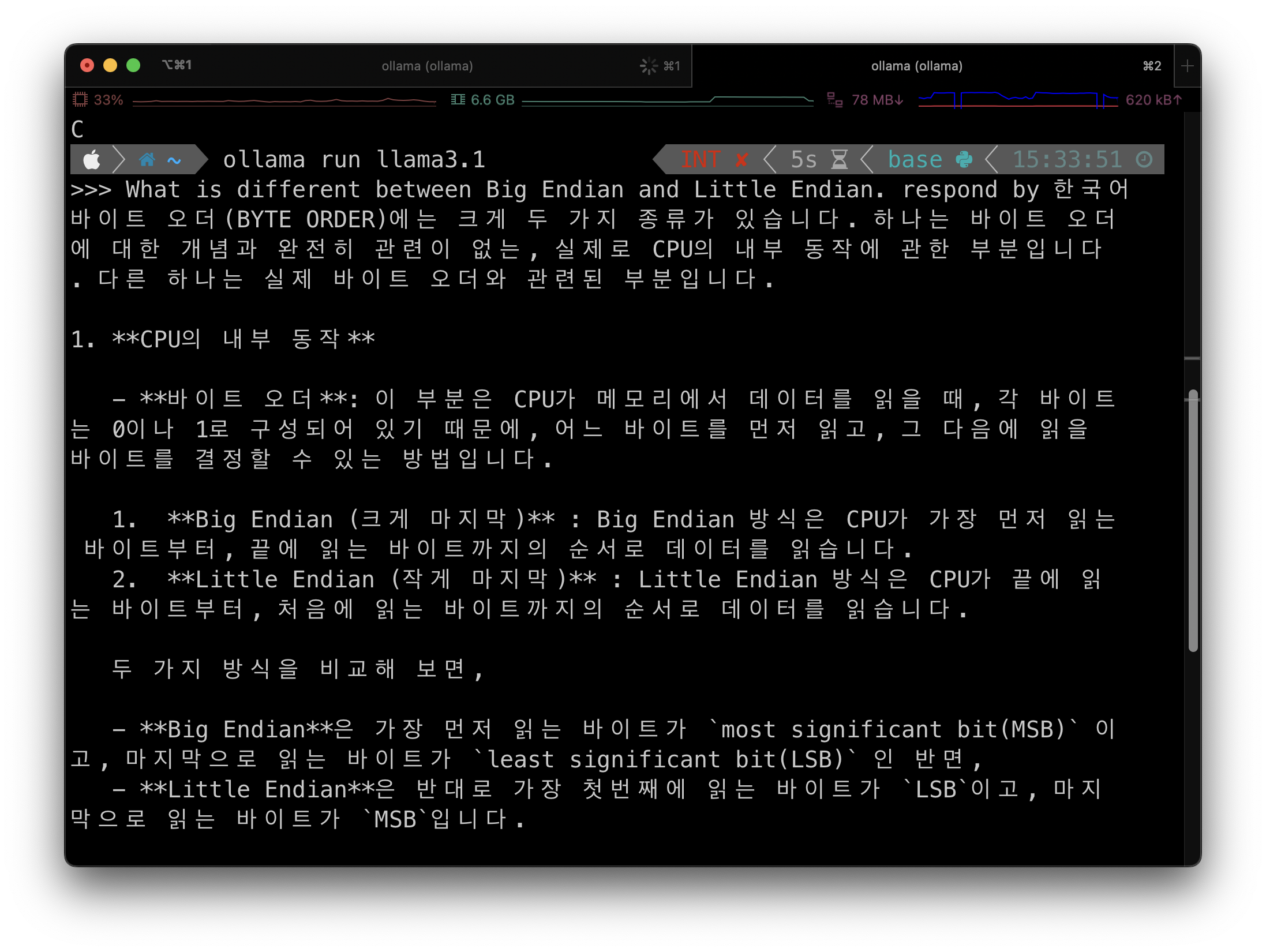

ollama run llama3.1

사용해 보기

입력 값: What is different between Big Endian and Little Endian. respond by 한국어

로컬 LLM의 꽃은 파인튜닝 아니겠는가? (사실 모름)

다음에 파인튜닝을 알아봐야겠다.

참고

Ollama란? Ollama 사용법: 내 PC에서 무료로 LLM 실행하기 | 코딩추월차선

Ollama를 사용하여 내 PC에서 무료로 대형 언어 모델(LLM)을 실행하는 방법을 알아봅니다. 설치부터 사용법까지 자세히 설명합니다.

www.developerfastlane.com

'Mac OS' 카테고리의 다른 글

| Xcode Beta 시뮬레이터 실행 (0) | 2024.07.15 |

|---|---|

| 한글 파일(.hwp) 무료 열기/수정/저장/보관 (0) | 2023.01.08 |

| 웨일 브라우저 유튜브 4k 화질 제한 해제 (0) | 2022.12.30 |

| LinearMouse - 맥에서 마우스 휠 작동을 윈도우처럼 (0) | 2022.12.24 |

| youtube-dl 쿠키로 유튜브 로그인 하기 (2) | 2022.12.14 |